Intelligenter Raum hört und sieht Nutzer

85 Mikrophone und acht Kameras als Computer-Interface

|

Vier der Kamera-Perspektiven im Smart Room (Foto: UPC/Plataforma SINC) |

Barcelona (pte032/05.02.2009/13:55) Forscher an der Universitat Politècnica de Catalunya (UPC) http://www.upc.edu arbeiten mit "Smart Room" an einem Projekt, das den Traum einer möglichst menschlichen Interaktion mit Computern zu verwirklichen hilft. 85 Mikrophone und acht Kameras im intelligenten Raum sind dabei die Augen und Ohren, mit denen ein projizierter sprechender Kopf Personen erkennen kann. Entworfen wurde der Smart Room schon 2004 im Rahmen des EU-Projekts CHIL (Computer in the Human Interaction Loop) http://chil.server.de , nun wird an weiteren Verbesserungen geforscht. "Im Audio-Bereich liegt ein Schwerpunkt auf der Erkennung akkustischer Ereignisse", erklärt der projektbeteiligte Wissenschaftler Josep Ramón Casas im Gespräch mit pressetext.

"Geräusche, die keine gesprochene Worte sind, werden normalerweise nicht erkannt", beschreibt Casas eine Einschränkung aktueller Systeme. Dabei sind für Menschen auch Schritte, das Geräusch einer Tür, die geöffnet wird, oder das Ablegen von Gegenständen Hinweise darauf, was um sie herum geschieht. Daher arbeiten die Forscher an der UPC derzeit daran, diese Möglichkeit auch mit ihren Algorithmen zu eröffnen. Dabei bauen sie auf den Ergebnissen von CHIL auf, denn das gesprochene Wort kann das System bereits verstehen und entsprechend reagieren. Dabei dient ein Teil der Mikrofone im Raum dazu, "eine Art Geräusch-Karte" zu erstellen, mit der Sprecher lokalisiert werden, so Casas. Dadurch können weitere Mikrofone für die Spracherkennung entsprechend ausgerichtet werden. Die Spracherkennung wurde außerdem mit ausgereifter Bilderkennung kombiniert, die neben Gesichtern auch Gesten interpretiert. Auf all das kann der projizierte Kopf entsprechend reagieren.

Ein Anwendungsbeispiel, das aktuell im Fachjournal "Personal and Ubiquitous Computers" vorgestellt wird, ist eine Lernumgebung. Der Lehrende kann beispielsweise darauf hingewiesen werden, wenn sich ein Student durch Handheben zu Wort meldet. Auch kann der Raum darauf hinweisen, wenn sich Lernende bei einer Aufgabe zu viel Zeit lassen oder geeignete Mitteilungen wiedergeben, wenn der Vortragende oder die Studenten den Raum verlassen. "Ich denke, dass einzelne Ideen aufs wirkliche Leben übertragen werden", meint Casas. Vorstellbar seien etwa Mikrophone, die Befehle verstehen und dann entsprechende Informationen auf Displays wiedergeben. Im Pflegebereich wiederum könnte eine geeignete Bildanalyse helfen, Gefahrensituationen und Notfälle schnell zu erkennen.

Das CHIL-Projekt war dabei noch ambitionierter, als nur die Interaktion zwischen Mensch und Computer zu verbessern, so CHIL-Mitarbeiter Joachim Neumann, der mittlerweile für Telefonica Research http://www.tid.es tätig ist. "Es ging darum, Computer für eine bessere zwischenmenschliche Interaktion zu nutzen", betont er gegenüber pressetext. Ein Beispiel dafür wäre, einem zu spät kommenden Teilnehmer an einem Meeting einen Überblick über dessen bisherigen Verlauf zu geben. "Das verbessert die zwischenmenschliche Interaktion, da der Betreffende gut informiert zum Meeting stößt und weniger stört", erklärt Neumann.

Damit die Forschungsergebnisse schneller auf reale Anwendungen übertragen werden können, wurden laut Casas auch gewisse Anforderungen an die Hardware gestellt. "Wir haben versucht, keine Hochleistungsrechner zu nutzen", erklärt der Wissenschaftler. Stattdessen kommt eine Reihe normaler Desktop-Geräte unter Linux zum Einsatz. Insgesamt werden zwölf Geräte für die Videoanalyse und sechs weitere für die Audioanalyse genutzt, so Casas.

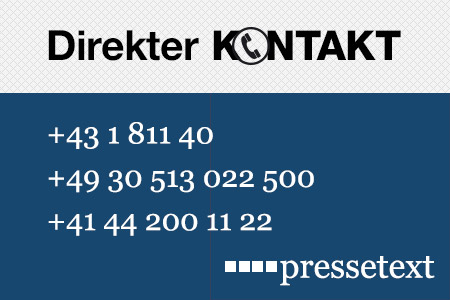

(Ende)| Aussender: | pressetext.deutschland |

| Ansprechpartner: | Thomas Pichler |

| Tel.: | +43-1-81140-303 |

| E-Mail: | pichler@pressetext.com |